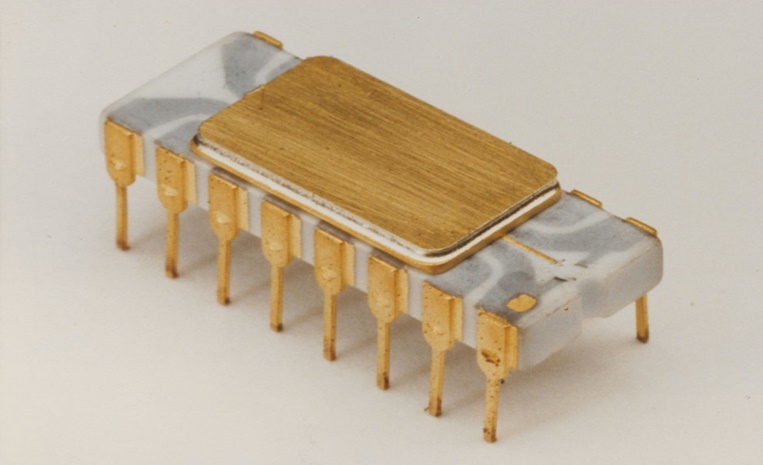

Cinco décadas depois de revolucionar o mercado, o Intel 4004 é um símbolo do ritmo galopante do mundo computacional. Em 15 de novembro de 1971, a empresa lançava seu primeiro microprocessador disponibilizado comercialmente, com 2 mil transistores, pouco perto das peças atuais, que chegam às dezenas de bilhões em uma superfície de alguns centímetros quadrados. Agora, essa tecnologia está cara a cara com novos paradigmas.

Ao voltar 50 anos no tempo, o passo histórico da Intel se mostrou um marco para a indústria, indicando o caminho de uma série de inovações que possibilitam processadores superpotentes na palma da mão, dentro dos celulares, e também em diversos equipamentos da vida cotidiana.

“Muito simplório para os dias atuais, com 4 bits, o 4004 conseguia fazer somente números inteiros de 0 a 15. Era uma capacidade de representação numérica muito limitada. Mas, na época, foi uma revolução', diz Eduardo Todt, engenheiro eletrônico e professor de Arquitetura da Computação na Universidade Federal do Paraná (UFPR).

Desde o invento, foi possível criar softwares para centralizar as tarefas. Foi na calculadora eletrônica a primeira aplicação do microprocessador.

“O 4004 teve papel transformador na indústria tecnológica e na vida das pessoas. Foi como um motor da transformação digital', afirma Carlos Augusto “Guto' Buarque, diretor de marketing da Intel Brasil.

Para ele, a vida conectada — desde o uso cotidiano de desktops, passando pelos conceitos de internet das coisas, casa inteligente e machine learning, até chegar ao emprego de supercomputadores para fazer simulações complexas — é consequência da evolução dos microprocessadores aliada a outras tecnologias.

O que temos hoje, poucos escritores de ficção científica imaginavam lá nos anos 1970

A calculadora que revolucionou hardware e software

O Intel 4004 nasceu a partir de uma demanda da fabricante japonesa Nippon Calculating Machine. Em 1969, ela pediu à Intel a criação de um conjunto de circuitos integrados para sua nova calculadora.

O projeto original previa 12 processadores, mas a equipe da Intel — Federico Faggin, “Ted” Hoff e Stan Mazor — optou por criar um conjunto de quatro processadores. Um deles era o que incorporava a CPU (central processing unit) 4004.

O processador, do tamanho de uma unha humana, podia ser programado de maneira mais flexível e, por isso, podia executar mais do que uma única tarefa — como calcular a raiz quadrada de um número.

“O 4004 podia ser usado de uma maneira mais customizável por software. Então, ele representou uma revolução tanto para o hardware quanto para o software', opina Buarque.

Lei de Moore: viva, morta ou transformada

Alguns anos antes do lançamento do Intel 4004, em 1965, Gordon Moore, cofundador da multinacional, escreveu um artigo em que previu que a complexidade dos componentes de um circuito integrado dobraria a cada ano. A observação ficou conhecida como Lei de Moore.

Em 1975, quatro anos após o surgimento do microprocessador, Moore revisou a lei, fazendo uma previsão de que a cada dois anos haveria, com o mesmo custo, em uma placa de circuito, o dobro de transistores — unidades básicas de um circuito eletrônico, que funcionam como uma chave que liga e desliga o circuito, fazendo operações lógicas.

Isso significa que, segundo a lei, os processadores seriam cada vez mais potentes e os transistores seriam fabricados em tamanhos progressivamente menores.

A previsão se concretizou e, mais do que isso, tornou-se uma meta que as indústrias almejavam atingir. Dessa forma, a busca pelo aumento da capacidade de processamento dos computadores, nas proporções descritas por Moore, provocou uma expansão no desenvolvimento tecnológico.

No entanto, as taxas não podem, em princípio, ser mantidas indefinidamente, uma vez que deve haver um limite para a redução do tamanho dos transistores. Essa ponderação trouxe à tona o debate acerca da possível morte da Lei de Moore.

“Faz uns 30 anos que a gente acha que está no limite da capacidade técnica', comenta Todt. O professor acredita que, em algum momento, esse máximo será alcançado, mas não se arrisca a apostar em uma data.

Enquanto o fim não se concretiza, os transistores continuam diminuindo, chegando a tamanhos como cinco nanômetros (cada nanômetro equivale a 10⁻⁹ metro), como o produto que deve ser lançado em 2022 pela Advanced Micro Devices (AMD).

Na Intel, ainda não se cogita estabelecer um limite quanto ao tamanho, muito menos se considera a morte da Lei de Moore, uma vez que a multinacional relaciona a previsão do seu cofundador muito mais à curva de desempenho dos processadores do que ao tamanho dos transistores.

Aqui, nós sabemos que a Lei de Moore não morreu. Existem diversas novas tecnologias que permitem que a gente continue inovando

E são múltiplas as alternativas pensadas para “superar' a Lei de Moore e encontrar novas formas de dar continuidade à inovação e ao aumento da capacidade de processamento.

Todt cita o processamento paralelo (que acontece, simultaneamente, a partir de vários núcleos) e os circuitos integrados verticais (quando se posiciona um transistor sobre o outro).

Outras alternativas consideradas pelas big techs são a computação quântica, a computação neuromórfica, novos layouts de transistores (buscando melhor desempenho e menor consumo de energia) e a substituição do silício por outros materiais que poderiam ser usados nas placas, como o grafeno.

“No caso do grafeno, há muitas questões a se pensar, como de onde ele vem, qual é o custo e quais são as vantagens', enumera Buarque. “Hoje, ainda não podemos dizer que o grafeno é o material que vai substituir o silício.'

Desafios e vantagens da computação quântica

Diferentemente dos computadores tradicionais, que registram informações a partir da passagem das correntes elétricas que atravessam os transistores, os computadores quânticos obtêm essas informações a partir de fenômenos relacionados a átomos, fótons ou partículas subatômicas.

Esse tipo de computação é uma alternativa para o desenvolvimento tecnológico, embora implique em novos desafios. Entre eles, Todt cita a necessidade de que esses computadores estejam em ambientes controlados, mantidos em temperaturas baixíssimas, como -272°C.

Outro desafio é a demanda de uma nova maneira de pensar em criptografia, uma vez que as formas de proteção de dados que existem hoje deixariam de ser eficazes.

“Toda a segurança que temos é baseada em algoritmos, em coisas muito difíceis de serem calculadas. Se você tem computação quântica, você consegue fazer esses cálculos na hora, e acabou a criptografia atual', destaca o professor.

Calculadora Busicom 141-PF (com papel), que usava o Intel 4004

Gordon Moore, fundador e presidente emérito da Intel

Robert Noyce, físico e cofundador da Intel

Microprocessador 4004, criado pela Intel em 1971

Microprocessador 4004, criado pela Intel em 1971

Para Buarque, a computação quântica ainda está longe de substituir a tradicional, devido à complexidade e aos altos custos. Ainda assim, ela pode trazer vantagens. “Mesmo que os computadores quânticos fiquem restritos a data centers, eles podem ter consequências diretas para as pessoas, resultando, por exemplo, em mais conectividade e em aplicações médicas que possam gerar remédios personalizados', comenta.

“Estamos com a computação quântica no horizonte, mas não estamos perto ainda', diz Todt. “Eu não diria que em cinco anos haverá grandes computadores quânticos ou coisa assim. Mas a gente pode ser surpreendido por alguma outra tecnologia', supõe.

Além da quântica, um tipo de computação em estudos é a neuromórfica, com circuitos eletrônicos que imitam a forma como o cérebro humano funciona.

O padrão buscado nesse modelo não se concentra na rapidez de processamento e de cálculo como nos computadores convencionais, mas tem maior eficiência em outros tipos de tarefas, como no reconhecimento de objetos. “Essa é mais uma área que pode trazer revolução tecnológica', diz Buarque.

Já Luciano Silva, professor do Insper, aponta três linhas de pesquisa — algumas mais, outras menos desenvolvidas — que surgem como tendências para o futuro da computação: processadores quânticos, fotoeletrônicos (baseados em luz) e bioeletrônicos.

Neste último caso, que parece o mais distante da atualidade para Silva, o silício é substituído por DNA, RNA ou proteínas. “A vantagem desses computadores moleculares é que, nesses materiais, consigo colocar bem mais informação do que 0 e 1', explica.

Leia destaques do CNN Brasil Business

O impacto ambiental de inovações com alto poder de processamento

Está em montagem atualmente, na AMD, um supercomputador com GPUs (graphics processing units) com 58 bilhões de transistores. O equipamento deve ser capaz de fazer 1018 cálculos por segundo.

Se todos os seres humanos fizessem um cálculo por segundo, nós levaríamos sete anos para fazer os cálculos que esse computador faz em um segundo

É uma tecnologia que tem implicações práticas no cotidiano das pessoas. “Parece estar na estratosfera, mas está na vida real', assegura Santos.

É com base nos problemas do dia a dia que o ser humano por trás das máquinas busca a inovação tecnológica. “O valor da tecnologia está em como ela melhora a vida das pessoas. Ela existe para encontrar respostas para os problemas que temos', diz Buarque.

Ele acredita que algumas das inovações que poderão trazer soluções no futuro são aparelhos que possam captar sons ambiente e transmiti-los ao cérebro, auxiliando pessoas com deficiência auditiva, e a criação de medicamentos personalizados, com base nas características e necessidades de cada pessoa.

“Isso requer um poder de processamento gigante', afirma. “Para não sair caro, é preciso que a tecnologia seja massificada.'

Segundo Santos, esse enorme poder de processamento significa que simulações gigantescas, que antes demorariam meses para serem concluídas, podem passar a demorar horas ou dias. Isso impactaria diversos setores, como o farmacêutico, uma vez que os remédios poderiam ser produzidos e testados mais rapidamente.

Outro exemplo são os crash tests (testes de impacto) da indústria automobilística. “Podemos fazer milhares de simulações virtuais antes de fazer as simulações no mundo real, amassando metal. Com essa tecnologia, conseguimos produtos mais seguros, de forma mais rápida', diz o gerente nacional da AMD.

Ele ressalta que esses testes também são usados na produção de vacinas. “Vimos pessoas desconfiadas porque, antigamente, levava-se anos para produzir uma vacina, e agora leva-se meses. Mas isso se deve ao aumento do poder computacional, que é usado justamente para isso, para acelerar esses processos', argumenta.

Com o crescimento do poder computacional, de acordo com Santos, é preciso levar em conta o impacto ambiental do avanço. “Sabemos que o planeta sofre para gerar energia. Então, temos hoje usuários mais conscientes da questão ecológica', afirma.

Precisamos pensar em reduzir o consumo energético para mantermos nossa vida digital

As formas de gastar menos energia ou de dispor mais transistores no mesmo espaço, seja em superfície ou empilhados, numa placa de silício ou em outro material, são os desafios que se apresentam para os próximos 50 anos.